Atsushi Nakatsugawa

December 19, 2025

2 min read

私が話すエンジニアリングリーダーは、例外なく同じ質問をしています。

「AIは本当に、私たちをより良くしているのか?」

「AIを使っているかどうか」ではありません(皆すでに使っています)。

「AIがコードを生成しているかどうか」でもありません(明らかに生成しています)。

さらには「コードの何パーセントをAIが生成しているか」でもありません(GoogleやMicrosoftのように、それを公表する場合を除いては)。

本当の問いは、AI導入が、より速く、より高品質なコードのデリバリーにつながり、エンジニアリングチームをより生産的で、より幸せにしているかどうかです。

問題は、ほとんどのツールが「見栄えのする指標(バニティメトリクス)」しか提供していないことです。

生成されたコード行数、受け入れられたAI補完の数。

これらは、AIがコードを書いた「その後」に何が起きているのかを何も教えてくれません。

そのコードはレビューを通過しているのか。

実際にデリバリーされているのか。

そして、本番環境を破壊していないのか。

CodeRabbitは、開発ライフサイクルにおいて独自の視点に立っています。

人間が書いたコードとAIが生成したコードの両方をレビューし、何が指摘され、何が受け入れられ、何がマージされるのかを見ています。

チームがどのように反復し、レビュアーがどう反応し、どこでストレスが生じるのかも観測しています。

私たちは、そこにチームにとって価値のある洞察があると確信していました。

そこで本日、その可視性をエンジニアリングリーダーの手元に直接届ける、新しい分析ダッシュボードをリリースします。

チームがAIツールを導入すると、ディレクター、VP、プラットフォームリードとの会話では、必ず次の3つの質問が中心になります。

1. レビュープロセスは速くなっているのか、遅くなっているのか?

AIによって生成されたコード(以下AI生成コード)は、PRの増加、差分の肥大化、そして従来とは異なる種類の問題を生みがちです。

レビュー工程がそれに追いついていなければ、スピードは向上していません。

ボトルネックを新たに作っているだけです。

2. コード品質は向上しているのか、それとも劣化しているのか?

コードが多いことは、良いコードであることと同義ではありません。

AIの支援による開発が、バグの早期発見やセキュリティ問題の削減、チームが定めた品質基準の維持につながっているかが重要です。

3. ビジネスに対してROIをどう証明するのか?

エンジニアリングリーダーは、ツールへの投資を正当化する必要があります。

「開発者が気に入っている」だけでは不十分です。

時間短縮、不具合防止、スループット向上といった、ビジネス成果につながる数値が必要です。

CodeRabbitのダッシュボードは、この3つすべてに答えます。

ダッシュボードは5つのビューで構成されており、それぞれ異なる種類の問いに答えるよう設計されています。

ここでは、各セクションでエンジニアリングリーダーが最も重視するポイントを説明します。

Summaryタブでは、リーダー向けの報告に必要な重要指標を一目で確認できます。

上のスクリーンショットでは、選択期間中に86人のアクティブユーザーによって145件のPRがマージされています。

これがスループットの基準値です。

Median Time to Last Commit

PRがレビュー可能状態になってから、開発者が最終変更を完了するまでの時間を示します。

短いほど、フィードバックループがタイトで、レビュアーの期待が明確であることを意味します。

ここが急増するのは、ボトルネックの兆候です。

Reviewer Time Saved

ROIに直接答える指標です。

CodeRabbitはシニアレビュアーの作業量をモデル化し、AIがどれだけ人間のレビュー時間を肩代わりしたかを推定します。

予算の議論では、節約されたエンジニアリング時間としてそのまま使えます。

CodeRabbit Review Comments

受け入れ率が低ければノイズが多いことを示し、高ければ信頼でき、行動につながるフィードバックであることを示します。

受け入れ率は品質のシグナルです。

レビュアーや作者が少なくとも半分のケースでCodeRabbitの指摘を反映しているなら、適切な問題を提示できていると言えます。

ドーナツチャートでは、コメントを**深刻度(Critical / Major / Minor)とカテゴリ(Functional Correctness、Maintainability、Security、Data Integrity、Stability)**で分類します。

これにより、CodeRabbitがどの種類の問題を捕捉しているのかが分かります。

Average Review Iterations per PR

1つのPRがマージされるまでに、平均で何回のレビューサイクルを経ているかを示します。

回数が多い場合、要件の不明確さ、PR品質の低さ、レビュアー過多などが疑われます。

時系列で追うことで、プロセスが引き締まっているか、緩んでいるかを判断できます。

Tool Findings

既存の静的解析ツールからの指摘をCodeRabbitが集約し、品質シグナルを一元化します。

Quality Metricsタブは、「CodeRabbitは正しいものを指摘しているか?」に答えます。

Acceptance Rate by Severity

深刻度ごとに、どれだけCodeRabbitのコメントが受け入れられているかを示します。

全レベルで一貫した受け入れ率があれば、チーム基準に適切に調整されている証拠です。

Acceptance Rate by Category

さらに以下のカテゴリ別に分解されます。

Data Integrity and Integration

Functional Correctness

Maintainability and Code Quality

Security and Privacy

Stability and Availability

これにより、CodeRabbitがどの領域で最も価値を提供しているかが分かります。

Securityの受け入れ率が低ければ、偽陽性が多い可能性があります。

Maintainabilityの受け入れ率が高ければ、コード品質の助言として信頼されていることを示します。

Bar charts

各カテゴリで、投稿されたコメント数と受け入れられたコメント数を示します。

どの種類の指摘が多いのかを定量的に把握できます。

Tool Findings

どの静的解析ツールが、どれだけの指摘を提供しているかを示します。

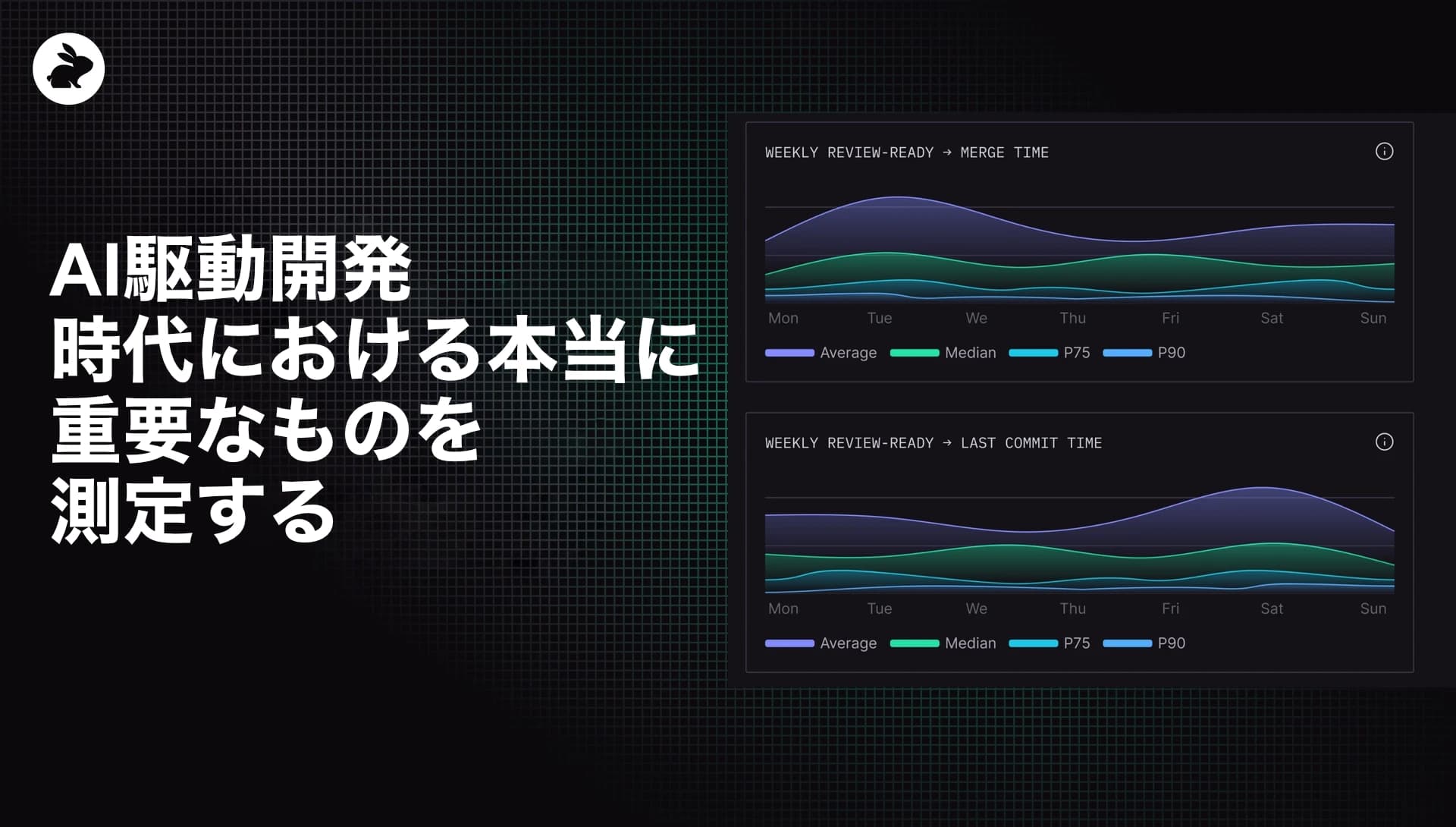

Time Metricsタブでは、レビュー工程におけるスピードを追跡します。

ボトルネックを特定し、改善するためのデータです。

Time to Merge

レビュー準備完了からマージまでの全期間を測定します。

上記例では次の値が示されています。

Average:1.2日

Median:1.4時間

P75:14時間

P90:4日

MedianとP90の差が示唆的です。

多くのPRは1.4時間でマージされますが、遅い10%は約4日かかっています。

このロングテールは調査する価値があります。

Time to Last Commit

開発者が最終変更を完了するまでの時間に焦点を当てます。

Average:2.4日

Median:4.5時間

P75:2時間

P90:5日

Time to Mergeと比較してください。

最終コミットが早いのにマージが遅い場合、コード完成後にPRが放置されています。

これは承認待ち、リリースゲート、不明確な責任分担が原因であることが多いです。

Time to First Human Review

人間が最初にPRを見るまでの待ち時間です。

Average:3.4日

Median:1.9時間

P75:3時間

P90:2日

Medianは2時間未満ですが、外れ値が平均を引き上げています。

右側の週次トレンドチャートで、改善しているか悪化しているかを追跡できます。

Organizational Trendsタブでは、時間軸での傾向を確認できます。

Weekly Pull Requests

作成・マージされたPR数を示します。

スクリーンショットでは、11月中旬から12月にかけて減少しています。

年末要因、優先度変更、バックログの兆候かもしれません。

Weekly Active Users

エンゲージメントを確認します。

10月下旬に落ち込みが見られます。

Weekly Pipeline Failures

CI/CDの健全性を追跡します。

CodeRabbit利用者の減少と、パイプライン失敗増加が相関していることが分かります。

Most Active PR Authors and Reviewers

貢献の偏りを把握できます。

複数のエンジニアが作成・レビューともに上位に集中しており、負荷過多によるバックログリスクが示唆されます。

Data Metricsタブは、監査性、コーチング、根本原因分析が必要なチーム向けです。

Active User Details table

各開発者のPR作成・マージ数、最終コミットまでの時間、コメント数、深刻度別の受け入れ率を表示します。

誰が頻繁に出荷しているか、誰のレビューが長引いているか、どのコードが重要な指摘を生みやすいかが分かります。

Pull Request Details table

個々のPRについて、リポジトリ、作者、作成時間、初回人間レビュー時間、マージ時間、推定複雑度、レビュアー数、コメント内訳を確認できます。

異常に時間がかかったPRや、特異なフィードバックパターンを深掘りできます。

Tool Finding Details table

静的解析ツールごとの指摘を、カテゴリ・深刻度・件数で一覧化します。

ノイズが多いルールや、価値の高いルールを特定するのに役立ちます。

私たちはソフトウェア開発の転換期にいます。

AIはこれまで以上に多くのコードを生成し、開発者は自分が書いていないコードをレビューしています。

エンジニアリングマネージャーは、AI投資が本当に成果を出しているかを証明する必要があります。

この移行をうまく乗り切れる組織は、自分たちのプロセスを可視化できている組織です。

「AIを使っているか」ではなく、**「AIがより良いソフトウェアをより速く出荷する助けになっているか」**を把握できているかどうかです。

CodeRabbitは、その問いに答えられる数少ないツールの1つです。

コードを見て、レビューを見て、何がデリバリーされるかを見ています。

そして今、これらのダッシュボードによって、エンジニアリングリーダーもそれを確認できるようになりました。

ダッシュボードは、すべてのCodeRabbitユーザー向けに提供されています。

リポジトリ、ユーザー、チーム、期間でフィルタし、組織にとって最も意味のある文脈でパフォーマンスを分析できます。

AIの影響を測ろうとしているエンジニアリングリーダーにとって、ここが出発点です。

興味はありますか?

14日間の無料トライアルで、今すぐCodeRabbitを試してください。